AR имеет множество разновидностей. Это характерно для любой технологии, находящейся на ранних стадиях развития и только обретающей форму. Пока что наиболее распространенным вариантом использования являются специальные фильтры, которые улучшают и украшают медиафайлы. В промышленных условиях ценными оказываются и функции ориентации в пределах прямой видимости.

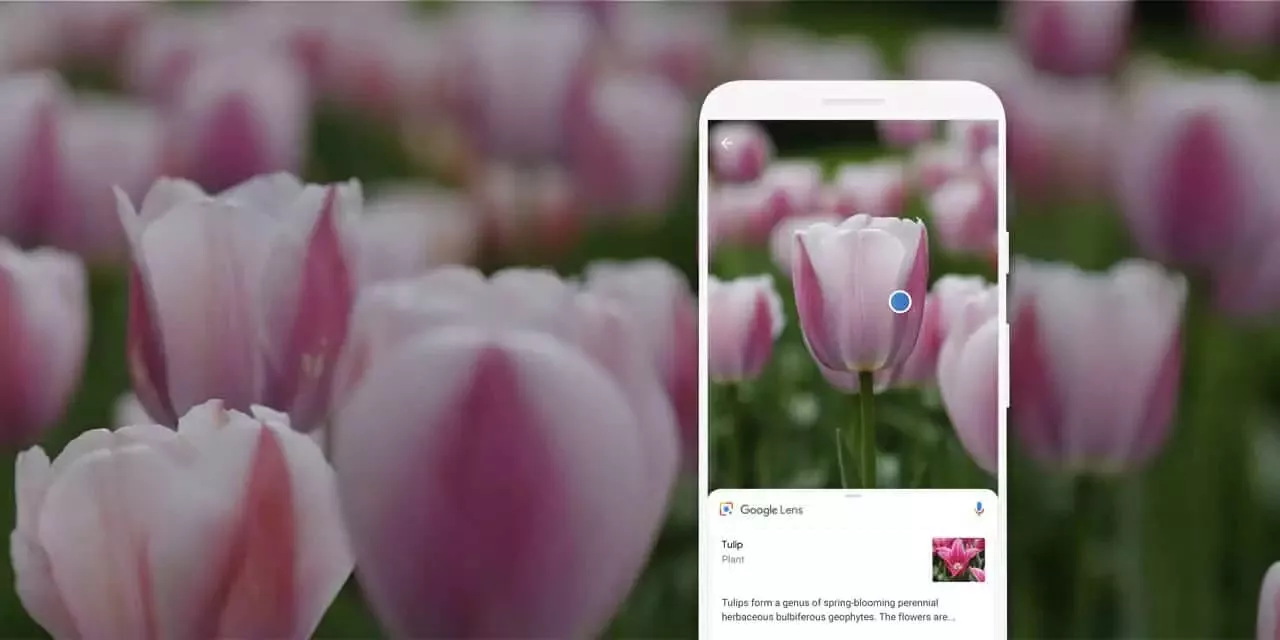

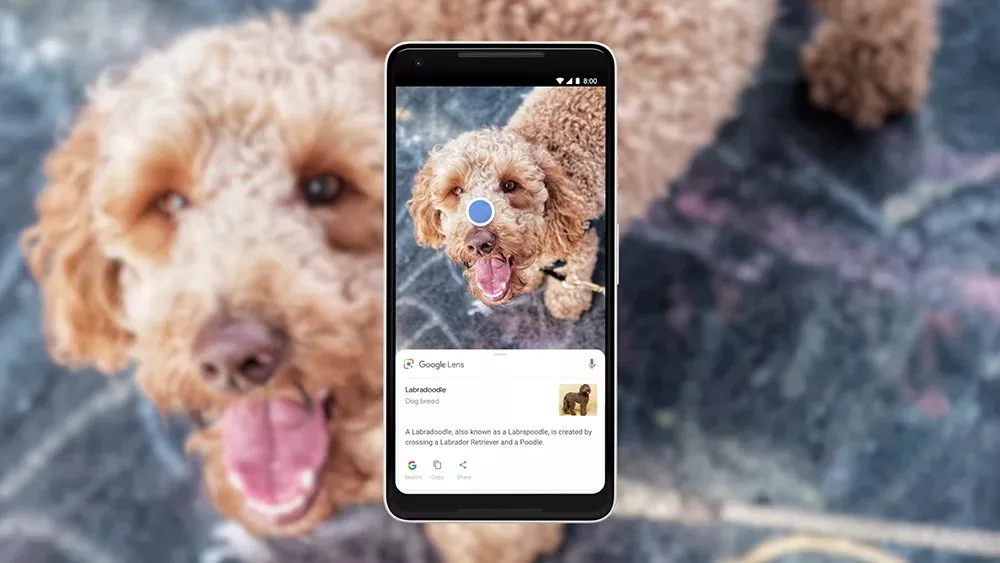

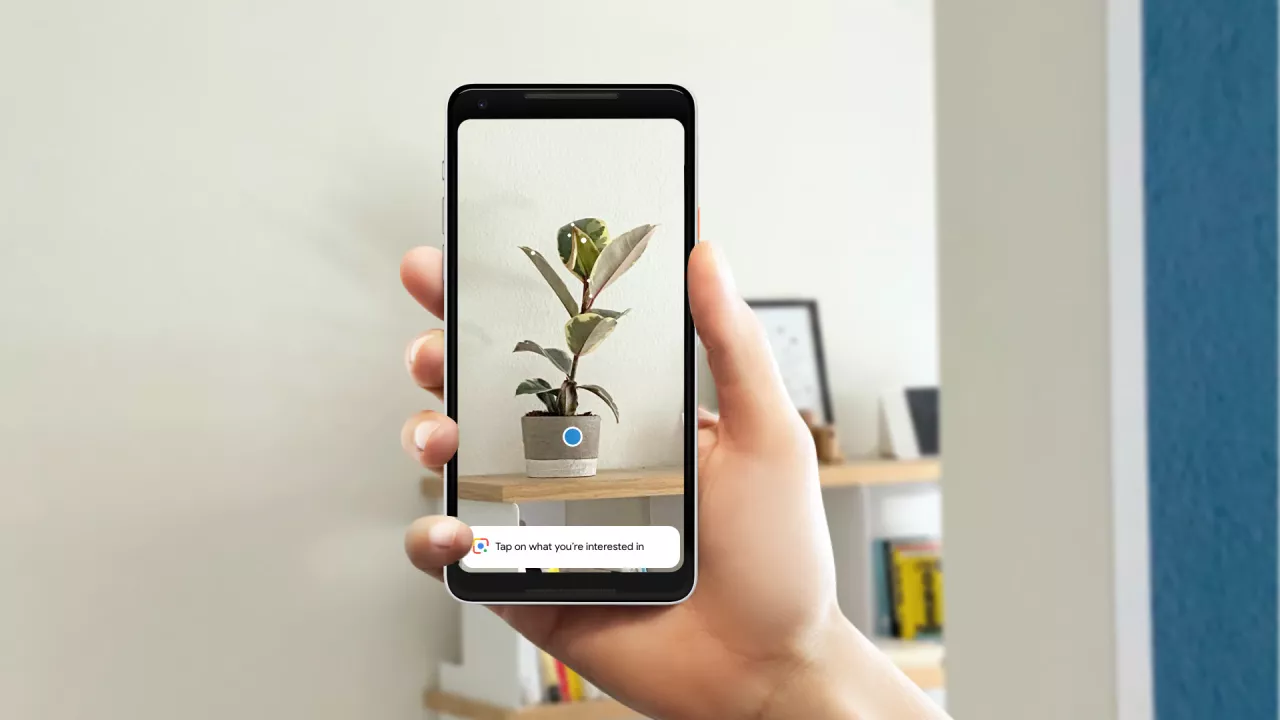

Но менее обсуждаемой AR-моделью является визуальный поиск. Этот вид поиска, основанный на технологиях Google Lens и Snap Scan, позволяет пользователям направлять камеры своих смартфонов (или в будущем очков) на объекты реального мира для их идентификации. При этом они контекстуализируют их с помощью информационных слоев... или «надписей для реального мира».

Это переворачивает представление об дополненной реальности: AR идентифицирует неизвестные объекты, а не отображает известные. Это расширяет потенциальные возможности применения, выходя за рамки заранее заданного опыта, который носит относительно узкий характер. Визуальный поиск охватывает весь физический мир.

Об этом говорится в недавнем отчете исследовательского подразделения компании ARtillery Intelligence. Он называется «Визуальный поиск: AR’s Killer App?», в нем подробно рассматриваются вопросы «что», «почему» и «кто» в визуальном поиске. Это самый свежий отчет из цикла еженедельных публикаций, в котором представлены основные моменты, касающиеся движущих сил и динамики визуального поиска.

Борьба за пространство

Одним из движущих факторов визуального поиска Google является геолокационный характер, поскольку он является продолжением десятилетий работы в области локального поиска. Например, локальный поиск и Google Maps составляют значительную часть доходов Google. Это объясняется тем, что локальные идентификаторы, такие как «рядом со мной», являются сигналами намерения пользователя.

Кроме того, визуальный поиск, основанный на физических местах, способствует реализации амбиций Google в области «Интернета мест». Этот термин, который еще называют «метаземля», определяет миссию Google по индексированию физического мира так же, как за последние 20 с лишним лет компания сделала огромный вклад в индексацию Интернета.

Это реализуется несколькими способами, включая Google Lens и Live View. Первый является основным продуктом Google для визуального поиска, позволяющим определять и контекстуализировать объекты, на которые вы направляете свой телефон. Сюда можно отнести моду и еду, а в «местном» варианте — определение витрин магазинов.

Двоюродный брат Google Lens, Live View, аналогичным образом позволяет пользователям ориентироваться в городских районах с помощью 3D-стрелок. Это может быть более интуитивно понятным, чем смотреть вниз на двухмерную карту. Для этого Google с помощью изображений Street View помогает устройствам распознать, где они находятся, а затем накладывает на них графические указатели.

Недавно Google объединила Lens и Live View в единый пользовательский интерфейс. При навигации по городским районам с помощью Live View Google отображает на сенсорном экране небольшие точки касания, если распознает витрину магазина. При нажатии на них появляется расширенная информация о компании.

Мотивированность и заинтересованность

Google может реализовать все вышеперечисленные функции, используя данные о предприятиях, которые он собирал в течение многих лет, — все, от времени работы до пунктов меню и политики использования масок в Covid. Переходя на новый уровень, компания хочет предложить возможности для визуального поиска, как только вы зайдете в магазин.

В Google Lens для этого используется компьютерное зрение и машинное обучение для обработки текста. Например, приложение может сканировать меню ресторана, чтобы найти ингредиенты, входящие в состав того или иного блюда. После этого оно может, например, информировать пользователей о содержании питательных веществ или дать рекомендации по заказу.

В перспективе Google Lens продолжает совершенствоваться как в плане возможностей, так и в плане позиционирования. По мере развития системы машинного обучения, например, она будет использоваться во все большем количестве областей. В их число входят такие хорошо знакомые места, как строка поиска мобильного приложения Google и адресная строка браузера Chrome.

Что касается возможностей, то Google продолжает добавлять новые функции для формирования целевого визуального стиля поведения покупателей. Например, функция «мультипоиск» позволяет пользователям комбинировать поисковые запросы. Они могут начать с визуального поиска, а затем сузить результаты с помощью текста (например, «такой же пиджак в синем цвете»).

В то же время Geo-local API Google использует возможности Live View и предоставляет их сторонним разработчикам для создания функций визуального поиска. Если все эти тенденции сохранятся, Google будет вкладывать все больше средств, стремясь сделать визуальный поиск действительно актуальным.

Комментарии

Еще нет комментариев.

Для участия в обсуждении нужно зарегистрироваться или войти со своей учетной записью.